2017/06/29

時間と空間を超える驚異の概念『テレイグジスタンス』に5Gの未来を見た

突然ですが「テレイグジスタンス」をご存じだろうか?

「TELE=遠隔」と「EXISTENCE=存在」を組み合わせた概念。ある対象と遠く離れていながら、あたかもそこにいるかのような感覚が得られるという新しい技術である。

提唱者である東大名誉教授の舘暲(たち すすむ)先生によると、テレイグジスタンスとは「ロボットとVRと通信があってこそ成り立つ技術」だという。

「テレオペレーション=遠隔操作」ということならば、たとえばドローンがある。でもこれは現状では「テレイグジスタンス」ではない。なぜなら、ドローンが飛ぶ姿を地上から見ながら操るから。実際にドローンに乗っているような感覚で操れるとすれば、それが「テレイグジスタンス」。

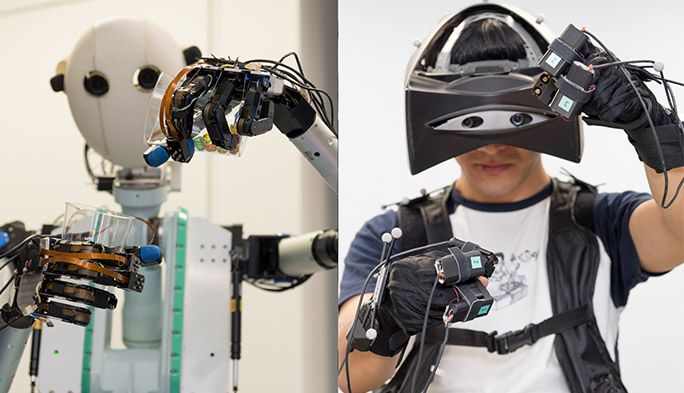

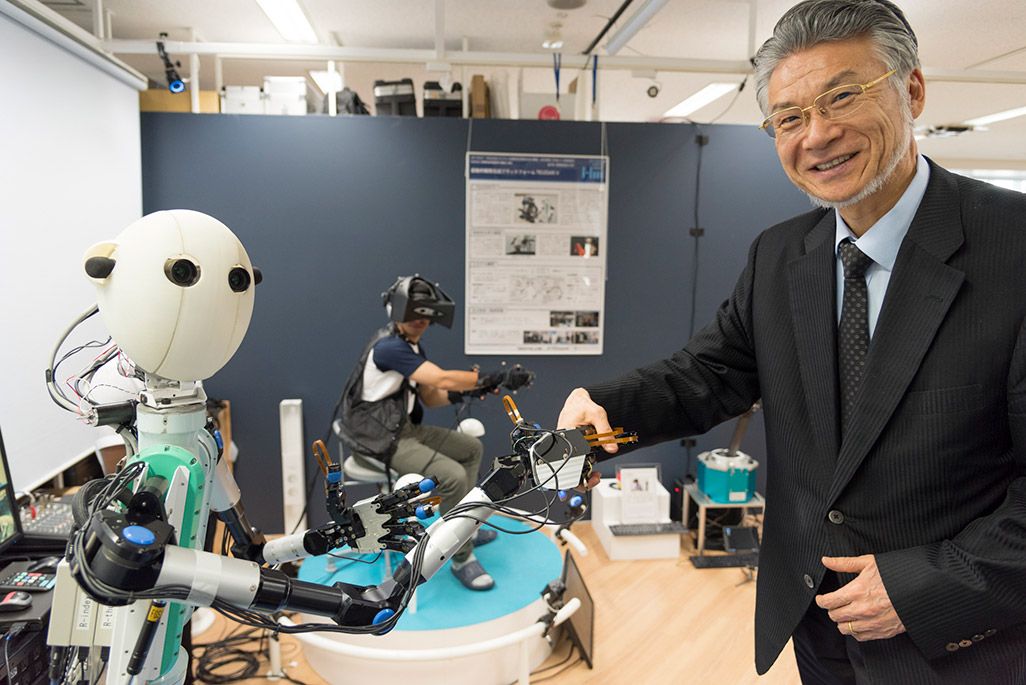

右が舘先生。で、握手しているつぶらな瞳の色白のコが「TELESAR V(テレサ ファイブ)」。テレイグジスタンスを実践するロボットである。そして奥にいるのが先生の研究室の方だ。写真をよく見ていただきたい。奥の研究室の方と手前の「TELESAR V」は同じポーズ。顔の向きまで一緒だ。これつまり、研究室の方の動きをそのまま「TELESAR V」がなぞっているということ。しかも完全にリアルタイムに動きがリンク。

その場で動けばロボットも同じように動く

で、実は現在、「テレオペレーション」は「テレイグジスタンス」に進化しつつある。実社会で活用されている好例としては医療ロボットの「ダヴィンチ」。アメリカのインテュイティヴ・サージカル社が開発した、内視鏡を使って手術を行うロボットで、医師は患者から離れたコンソール(制御卓)を操って施術する。内視鏡カメラが捉えた術野を3D画像で立体的に見ることができるので、血管の縫合など細かい作業が行いやすくなる。

しかし、触覚がないため、医師には「ダヴィンチをコントロールする」という新たなスキルが必要になる。厳密にいうと、それは「実際にメスを手にして行う手術」とは別だ。

それをさらに進化させ、触覚をも伝えて、特別なスキルを新たに学ぶことなく、「普段メスを手にして行う手術」のスキルさえあれば、遠隔地からでも実践できるのが「テレイグジスタンス」なのだ。

実際に体験させてもらった。

ほら、完全に人の動きと同期してますよね?

じゃんけんして負けて頭を抱えるの図がご覧いただけると思う。

この時、自分のすべての感覚はロボットに憑依しているのである。たとえば動画の26秒あたり、右のオジサン(筆者だけど)が「わーっ」て叫んでいますが、自分の両手を見ているはずなのに、そこにあったのがロボットの手なのである。ちなみに、ヘッドマウントディスプレイ越しに見ている世界の様子は足もとのディスプレイに映し出されている。

で、左を見ると、自分の姿がそこにある。「ああ、自分で思っているよりも後頭部が薄いなあ」とかわかる。行動の主体は自分自身のはずなのに、自分の見ている先に自分の姿がある。これ、ちょっとした幽体離脱感覚。「あそこにオレがいる。ということはオレを見ているオレは一体誰だ?」という「粗忽長屋(そこつながや)」的な感覚がまさに体感できるのである。「粗忽長屋」については古典落語の傑作なので、ググっていただきたい。

実験ブースには、手からの位置を捕捉するセンサーが上部に4個、下部に4個設置されている。

手袋から出ている白い球状のモノが、センサーが感知するための目印。指先の四角いモノが、ロボットが指先を触れられた時に感じた「圧」などを人間の指先に伝えるデバイスだ。

左モニターに映る赤いのがロボットで、ブルーはそれをコントロールする人間。動きがシンクロした状態になると、右モニターのように完全に重なって、一体に見える。

なんと「テレイグジスタンス」の発想は37年前。

こんなとんでもない技術に、どうやって到達したのだろう。舘先生に尋ねてみると、なんと最初の発想は1980年だったという。今から37年(!)も前の話だ。

t「我々が世界を見るときに、世界はそのまま見えているわけではなく、網膜に映った、実際とは逆向きの映像を脳内で補正して再構成して“実際の世界”として認識しているんです。世界のすべてを正しく把握して受け止めているというわけではないのです。」

a「なるほどなるほど。」

t「ということは、人間が脳内で世界を再構成するために必要十分なデータを与えれば、限られたデータでも、あたかも“自分で体験している”というような感覚を与えることもできるのではないかと思ったのです。そしてそれは、人間の計測技術、ロボットの制御技術、人間への提示技術、加えて遠隔地からでも通信技術を使うことで可能になるのではないかと。」

a「どういうふうに思いつかれたんですか?」

t「盲導犬ロボットの研究で、盲人用提示装置の設計評価の方法を呻吟(しんぎん)しているとき、なぜか、ふっとそのようなことを思いついたわけです。それから、テレイグジスタンスの概念に至るまでは一瀉千里(いっしゃせんり)でした。1980年9月19日のことでした。」

最初につくったのは頭と目だけのテレイグジスタンス装置。これにより自分自身を見た時の幽体離脱体験は、いまでも鮮明に覚えているという。次にそれをビークル、いわば小さな乗り物に乗せた。テレイグジスタンスカメラを搭載し、そこからビークル目線の視界が得られる。今でいうカメラ付きのドローンである。とはいえ完全に“そこに乗っている目線”で遠隔操縦する感覚は、まぁなんとなく想像がつく。

先生がその次に取り組んだのは、人間型ロボットを自分の新しい身体にすること。そしてものを感じる「触覚」だった。

a「遠隔地で働いているアバターロボットの「感触」は操縦者にフィードバックできるんですか?」

t「人間の網膜には錐体(すいたい)細胞というものがあって、そこで光の三原色であるR(Red)とG(Green)とB(Blue)に分解することで色を認識しています。この原理を使わず、世の中のすべての光のスペクトルをそのまま記録し伝送して再生しようとすると、とてつもない装置が必要になります。でも人間は、RGBに分解した時の数値が等しければ、誰でも同じように“その色”として認識できる。つまり視覚情報については、すべて三原色の原理に基づいてRとGとBに分解すればいいだけなので、汎用的に記録し伝送し、再生できるわけです。」

a「ええと、つまり・・・・・・。視覚的な世界は数値化し、同じものを再現することが比較的簡単にできるということですね。」

t「ええ。しかし、“触覚”には視覚でいうところのRGBのように、すべての触感を、それにより数値化できるものが存在しませんでした。」

a「その原理を舘先生が発見されたんですか。」

t「人間の感覚器が、なにに対して反応するかをつぶさに調べていったのです。すると、“振動・力・温度”で、おおむね提示することができるとわかった。それを光の三原色になぞらえて“触原色(しょくげんしょく)”と呼ぶことにしました。」

こうして触覚は「振動・力・温度」で数値化できることがわかった。あとはそれら触原色を感知、数値化するセンサーをロボット側に、再現するデバイスを人間側に装備。かくしてロボットと操縦者の感覚を“同期” させることができるようになったというわけだ。

先ほどお見せした、この指先の四角いパーツには、「振動・力・温度」を再現する機能が搭載されている。

実際、握手されると、ギュッと握られてる感がしっかりと伝わってくる。当然、実際に操縦者は誰とも握手はしていない。これはなかなか不思議な感覚だ。

また、こんなこともできる。

左手に持ったプラスチックのコップに入ったビー玉を右手のコップに移し替える。それだけの作業だが、たとえばゲームのコントローラといった“代換装置”でやると、めちゃくちゃ大変そうだ。コップを持つ強さ・高さ・位置・傾けるスピード、あと受ける側との距離なんかを全部キー操作でやらないといけないから。

テレイグジスタンスなら操縦者が「左手に持ったプラスチックのコップに入ったビー玉を右手のコップに移し替える」だけで、ロボットも同じ動作を、リアルタイムにしてくれるというわけだ。

「テレイグジスタンス」はどう発展していくのか?

2017年1月に、その名も「Telexistence株式会社」(以下TX Inc.)が誕生した。舘暲先生を会長に、ロボティクス、VR、触覚技術の専門家たちで構成されたこの会社、まさにテレイグジスタンスをビジネスにしていこうとしているのだ。

なお、TX Inc.には、今年5月、KDDIが「KDDI Open Innovation Fund」を通じて出資を行っている。

考えるだけでSFチックなこの技術をどんなふうにビジネスにしていくのか。この日、デモに立ち会ってくれた同社CEO富岡仁さんと、COO彦坂雄一郎さんにお話を聞いた。

左/Telexistence株式会社 CEO富岡仁さん。右/Telexistence株式会社 COO彦坂雄一郎さん

左/Telexistence株式会社 CEO富岡仁さん。右/Telexistence株式会社 COO彦坂雄一郎さん

3「テレイグジスタンスって、時間とか移動のコストをかけずになにかの作業、体験を遠隔からできるという点が価値の源泉だと思っています。今、実際に進めているのは、ある旅行会社さんとの“新たな旅行体験”。たとえば美術館。実際に現地にテレイグジスタンスロボットを置き、インターネット経由でロボットを操って、館内を移動しながら鑑賞する体験をする。弊社としては地方自治体と連携し、地方の観光資源をテレイグジスタンスを使ってその価値を最大化したいと考えています。」

4「たとえばロボットの足元にセグウェイみたいな機構を採用すれば、人間は遠く離れた場所で体を傾けることによって館内を移動できるかもしれません。触れる彫刻などがあればロボットに触らせてその感触も楽しむことができるでしょうし。」

おそらくそのためには、今回の実験ブースにあったような、人間の動きを感知するセンサーを備えたスペースが必要になるだろう。だが、テレイグジスタンスのための具体的なUIに関しては、現状は未定らしい。

具体的に進んでいるプランはまだある。百貨店での“新たな購買体験”だ。彦坂さんは、実際に店内にロボットを置き、自由に売り場を行き来しながら、将来的には生地の素材感まで確認しながら買い物ができるようになるかもしれないという。

4「地方から都市への、あるいは海外への、具体的に移動を伴わないアプローチが可能になると考えています。そういう動きが活発になってくるのではないでしょうか。」

TX incには慶應義塾大学メディアデザイン研究科特任講師であり、「TELESAR V」をつくり上げた中心メンバーであるチャリス・フェルナンドさん(動画内で「TELESAR V」の調整をされている方)が、CTOとして参画している。この3人を中心に、テレイグジスタンスロボットは2019年上期を目途に量産化・実用化を目指しているという。

テレイグジスタンスがもたらす「働き方革命」とは?

Telexistence社ウェブサイト。人間がロボットに、ロボットが人間に乗り移るイメージだ

Telexistence社ウェブサイト。人間がロボットに、ロボットが人間に乗り移るイメージだ

そして、こうした短期的なビジョンと並行して研究を重ねているのが、テレイグジスタンスを使った働き方の改革である。

まさに文字どおり、診断だけでなく手術まで行えるような遠隔医療や、現場に行かなくても建機や重機を操ることができる事業の話。

3「医療は規制を含めて難易度が高いので、おそらく先に建築現場でしょうね。これは実際に企業さんとディスカッションしています。実はすでにiPadなどを使ったショベルカーの遠隔操作なんかは行われているのです。でも技術者の方が言うのは“土を掘った時の振動が伝わってこない”ということ。その感覚って実際に仕事をするうえでは非常に重要なのです。現状の遠隔操作方法だと、やはり生産性が格段に落ちてしまうそうです。テレイグジスタンスを使えば、振動や反力を感じながら操作することができるので、技術者としての経験をそこできちんと生かせますよね。」

なるほど熟練の技を持った人が、たとえ現場とは離れた遠隔地にいてもテレイグジスタンスによって“いつも通りの感覚”で仕事ができるようになる。

4「その先で僕たちがやりたいと思っているのは “ロボットN体(多体)”の世界です。ひとりの職人さんの動きに、複数台のロボットが同期して同じ動きができるようにする。テレイグジスタンスを用いてAIで学習させたロボットは、職人さんと同程度の作業ができてしまう。これで、日本の生産性は著しく変わりますよね!」

職人技や医療技術などを人とロボットが共有しようとなると、まずは両者の間の感覚を伝達する精度が非常に重要になってくる。そこで俄然、重要度が増してくるのが「通信」である。

テレイグジスタンスの可能性を、5Gがさらに広げる。

舘先生は、冒頭、テレイグジスタンスを構成する3つの要素を挙げた。そのなかで唯一、先生のラボで進めることができないものがある。巨大なインフラを利用する「通信」のシステムである。

最初、視覚と聴覚だけから始まったテレイグジスタンスロボットは触覚を得て大きく発展した。「これから登場してくる5Gも非常に大きいと考えています」と舘先生。

t「通信するデータとしてもっとも容量が大きいのは視覚です。ただ、それは今もさほど遜色ない。超高速・大容量という要素もさることながら、5Gでもっとも期待しているのは、“低遅延”だということですね。通信の遅延が1ミリセカンドにまでなりますから、さまざまな細かい作業の感覚を伝達するうえで非常に重要だと思います。テレイグジスタンスは、ロボットとVRと通信技術があってこそだと思っています。」

ビー玉の移し替えや、生地の感触を伝えるのに、ロボットのセンサーと人間のデバイス間の感覚に多少遅延が生じても、それほど問題はないだろう。だが巨大な建機を動かす工事現場や、指先の感覚が作品の出来を左右する職人の工房、0コンマ数ミリの誤差で命を左右する医療の現場などで、今後、テレイグジスタンスを実用化していくには、通信のチカラは欠かせないようだ。

t「テレイグジスタンスが普通になると、人間の感覚そのものが変わると思います。現状は視覚聴覚と手と上半身だけですが、身体全体を共有できるようになる研究も進めています。人間の能力を、時間、空間的に拡張する。毎日決まった場所に通わなくても働けるわけですし、それぞれの技術をロボットに学習させることもできる。自分がそこに行かずして、自分がそこにいるような感覚。だから『どこでもドア』によく例えるのですけどね。映画の『アバター』よりは、私のほうがずっと前に思いついていましたから(笑)。思ったことが実践できるというのは、ようやく時代のほうが追いついてきてくれたのかもしれません。」

文:武田篤典

撮影:稲田 平